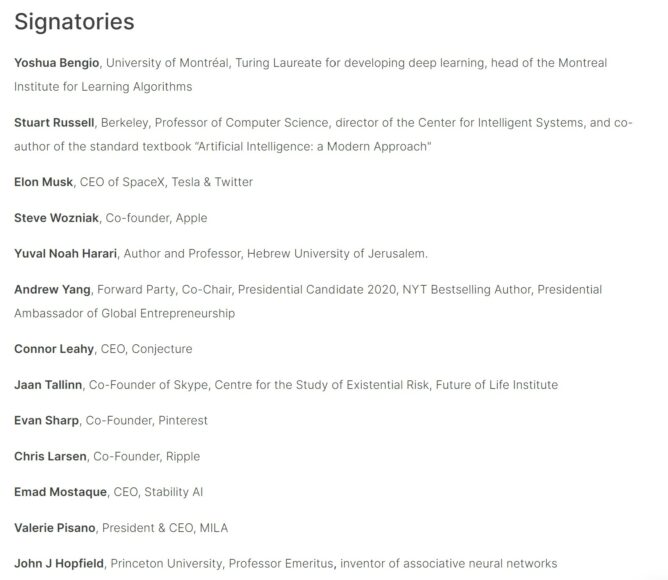

Elon Musk、Apple 聯合創辦人 Steve Wozniak及Stability AI 總裁 Emad Mostaque 等科技界別巨頭,連同其他科技業人士和學者聯名發出公開信及發起聯署行動,表示希望所有比 GPT-4 更強大的 AI 能夠暫停訓練起碼 6 個月,以開發出適用於設計及開發高級人工智能的「共同安全協議」,確保 AI 系統不會對人類造成威脅。

▲圖片來源:Future of Life

公開信中表示,有大量得到頂級 AI 實驗室認可的研究顯示,智能足以媲美人類的 AI 系統可能會對社會及人類帶來深遠的危機。最近數月各大人工智能實驗室陷入一場失控的軍備競賽,每個實驗室都爭相開發更強更大型的人工智能模型,但是包括 AI 的創造者在內,沒有人能夠透徹地理解、準確地預測或穩當地控制 AI 。

公開信中引用 OpenAI 內部評估,表示 GPT-4 在一般任務上已經能夠媲美人類,甚至與人類相比亦具有競爭力。公開信提出,AI 或會被利用作不實宣傳,使虛假信息充斥著人類溝通渠道;同時信中又指,倘若繼續無序開發非人類大腦(AI),最終 AI 的數目和智慧都會勝過人類,人類或會面臨被淘汰及取代的風險,故此我們不應該冒險在不受限制下開發 AI,以免 AI 在未來未經選舉成為領袖,人類亦會失去對文明的控制。

當然,科技巨頭們的聯署信並非一面倒式反對發展 AI。聯署信中表明,當人類能夠確定 AI 系統的影響是正面且能夠完全控制風險時,方為適當時候開發更強大 AI 系統。

OpenAI 上月(2 月)24 日亦發聲明稱「到了某個階段,需要先經過獨立審查才能夠開始訓練未來新 AI 系統,這件事非常重要,而且所有資源應該最優先用於限制新 AI 系統的運算能力。」(”At some point, it may be important to get independent review before starting to train future systems, and for the most advanced efforts to agree to limit the rate of growth of compute used for creating new models.”)

▲OpenAI 上月 22 日發出的聲明

公開信表示現在就是該設限的時候。他們現在呼籲全球所有 AI 實驗室立即停止訓練比 GPT-4 更強大的 AI 系統,為期最少 6 個月,利用這段時間共同開發一套共同安全協議,限制設計及開發高級人工智能系統,並由外部獨立專家進行審核和監督,以確保 AI 系統安全可控。如果不遵守暫停令,公開信中建議政府介入強制暫停開發工作。

公開信重申,不是要求徹底停止一切 AI 開發,而是希望開發者能夠臨崖勒馬,停止現在這種危險的軍備競賽式無序開發工作,因為現在連 AI 的創造者也不能透徹了解及肯定自己能夠完全控制 AI。

公開信建議 AI 開發人員與政府合作,最少需要跟從以下規定:

- 設立專門負責 AI 監管的新部門;

- 嚴格監督及追蹤高性能 AI 及具有大型運算能力的機構;

- 在 AI 生成的作品加入出處和水印等識別系統,以區分該作品孰真孰假及追蹤模型泄漏;

- 設立強大的審核和認證系統;

- 為人工智能安全技術研究設立大額公用資金;

- 設立資源充足的機構以應對 AI 可能造成的經濟和政治破壞(尤其針對民主方面)

▲參與聯署的部分科技界知名人士

資料來源:Future of Life、Arxiv.org、OpenAI

分享到 :

最新影片